------La inteligencia artificial se está utilizando como arma en todas las facetas de la vida, y el reciente cambio de principios de Google es una señal de lo que está por venir.

La semana pasada, Google revisó sus principios de inteligencia artificial, eliminando la postura de la compañía contra el uso de IA para desarrollar armas o tecnologías o facilitar directamente lesiones a personas, o para una vigilancia que viole las normas internacionalmente aceptadas.

Demis Hassabis, jefe de inteligencia artificial de Google, dijo que las directrices se estaban revisando en un mundo cambiante y que la IA debería proteger la "seguridad nacional" .

RT entrevistó al Dr. Mathew Maavak , consultor senior de la Hoja de Ruta Nacional de Inteligencia Artificial 2021-2025 (AI-Rmap) de Malasia, experto en riesgos globales, geopolítica, previsión estratégica, gobernanza e IA, sobre las posibles consecuencias de las nuevas políticas de Google.

RT: ¿Significa esto que Google y otras corporaciones comenzarán a fabricar armas impulsadas por IA?

Dr. Mathew Maavak: En primer lugar, Google fue en gran medida una creación del aparato de seguridad nacional de Estados Unidos o, simplemente, del “estado profundo” .

Los orígenes de muchas, si no todas, las grandes entidades tecnológicas actuales se remontan a las investigaciones pioneras llevadas a cabo por la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA) de Estados Unidos y su predecesora, la Agencia de Proyectos de Investigación Avanzada (ARPA).

Por lo tanto, la entidad cuasi privada llamada Google está inextricablemente ligada a sus orígenes de “seguridad nacional” , al igual que otras grandes entidades tecnológicas.

La fabricación de armas con IA y la creación de armas impulsadas por IA es una progresión natural para estas entidades. Microsoft ha establecido desde hace mucho tiempo su propio “ imperio militar ” .

Además, las plataformas de las grandes tecnológicas se han utilizado ampliamente para actividades de recopilación de datos e inteligencia en todo el mundo.

Esta es una de las razones por las que China ha prohibido muchos programas y aplicaciones de las grandes tecnológicas estadounidenses. ¡Una nación no puede ser soberana si está en deuda con las grandes tecnológicas!

En cuanto al cambio de las directrices de Google sobre IA, no debería sorprendernos. Las grandes empresas tecnológicas promovían activamente modelos universales de gobernanza de la IA a través de diversas instituciones de alto perfil, agencias de las Naciones Unidas, organizaciones no gubernamentales (ONG), centros de estudios y gobiernos nacionales.

A través de mi reciente trabajo en este campo, se hizo evidente que el gobierno de Estados Unidos buscaba sofocar el desarrollo de la IA autóctona en todo el mundo mediante la promoción de modelos de gobernanza de la IA poco elaborados y ampulosos, plagados de contradicciones. La brecha entre las aspiraciones elevadas y las realidades de larga data es simplemente insalvable.

El mismo manual se utilizó para impulsar los esquemas ambientales, sociales y de gobernanza (ESG) en todo el mundo, lo que impuso altos costos tanto a los países en desarrollo como a las corporaciones. Ahora, Estados Unidos y el gran capital están abandonando los mismos esquemas ESG que habían ideado.

Lamentablemente, muchos países cayeron en estas trampas e invirtieron importantes cantidades de dinero y recursos en la creación de marcos ESG y de IA extravagantes. Estas naciones corren el riesgo de volverse permanentemente dependientes de las grandes empresas tecnológicas en el marco de lo que yo llamo “neocolonialismo de la IA” .

Google y YouTube de Alphabet, Bing de Microsoft y X de Elon Musk ya habían utilizado sus plataformas como armas antes de este cambio reciente en la política de inteligencia artificial.

Los algoritmos de búsqueda de las grandes empresas tecnológicas se han utilizado como armas para borrar a los disidentes y las plataformas contrarias del panorama digital, imponiendo de hecho una damnatio memoriae moderna .Tengo que utilizar el motor de búsqueda ruso Yandex para recuperar mis artículos antiguos.

RT: ¿Por qué se hace este cambio ahora?

Dr. Mathew Maavak: Todos los sistemas de armas dependen cada vez más de la IA. El conflicto entre Rusia y Ucrania ha sido testigo del uso de la IA en el campo de batalla. El uso extensivo de drones, con posibles capacidades de inteligencia de enjambre , es solo uno de los muchos ejemplos anecdóticos del uso de la IA en Ucrania. No se pueden crear armas y contramedidas de próxima generación sin IA. No se puede llevar un cuchillo a un tiroteo, como dice el viejo refrán.

Cabe señalar que uno de los sectores más rentables y con mayor futuro, con rentabilidad garantizada de las inversiones, es el complejo militar-industrial. La fabricación de armas impulsadas por IA es una línea de acción natural para las grandes empresas tecnológicas.

También es muy revelador que los líderes de las dos superpotencias de la IA (Estados Unidos y China) no hayan asistido a la reciente Cumbre de París sobre IA .

El evento se convirtió en una tertulia orquestada por las grandes tecnológicas. Junto con el Reino Unido, Estados Unidos también se negó a firmar la declaración sobre la necesidad de que la IA sea “segura para todos”.

Claramente, este evento fue organizado para suprimir la innovación en IA en los países en desarrollo y, al mismo tiempo, legitimar el uso de la IA como arma por parte de las grandes potencias.

RT: Los “principios” de Google, para empezar, los establece la propia Google, son voluntarios y no vinculantes según ninguna ley. Así que, en teoría, nada impedía a la empresa seguir adelante con cualquier tipo de investigación de inteligencia artificial que quisiera. ¿Por qué sintió la necesidad de hacerlo “oficial”?

Dr. Mathew Maavak: Los llamados “principios” de Google nunca fueron determinados por la empresa en solitario. Fueron una simple concesión al público, perfectamente resumida en su lema risiblemente cínico: “No seas malo”.

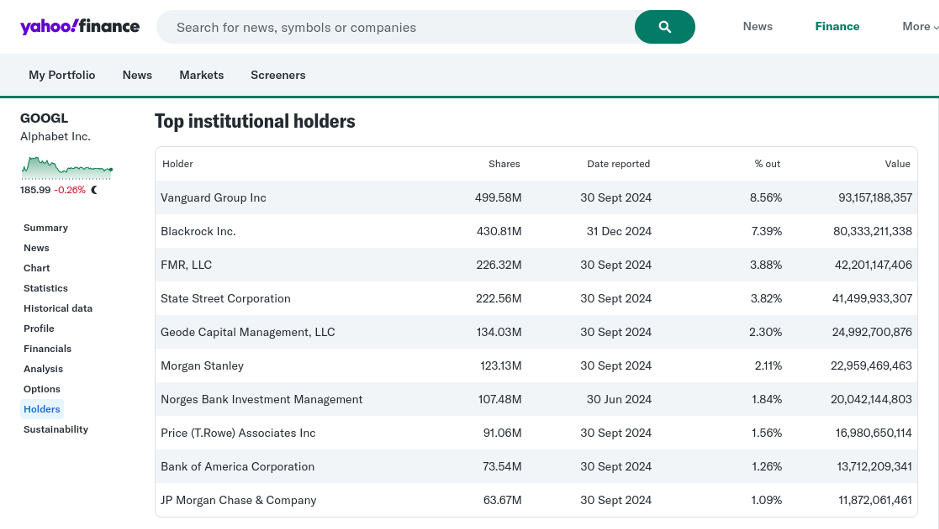

Su empresa matriz, Alphabet, es propiedad de los sospechosos habituales del gran capital, como Vanguard, BlackRock, State Street, etc., todos ellos brazos privados del estado profundo estadounidense.

Captura de pantalla tomada el 11 de febrero de 2025 © Mathew Maavak

Una entidad como Google no puede realizar “ningún tipo de investigación en IA”, ya que sus actividades deben ajustarse a los dictados de sus principales partes interesadas. Google formalizó su nueva política de uso de armas porque la participación del público en su pastel de propiedad es prácticamente inexistente.

RT: ¿Es hora de crear leyes internacionales respecto de la IA militar, como los principios de Google antes del cambio reciente, pero que sean aplicables?

Dr. Mathew Maavak: Como he mencionado antes, varios modelos internacionales de gobernanza de la IA (todos ellos prácticamente una imitación de otros) fueron formulados subrepticiamente por empresas como Google, Microsoft, Amazon y otros miembros de los llamados Tech Bros. A las naciones se les dio simplemente la ilusión de tener una participación en esta matriz legal y ética de la IA global. Los burócratas simplemente aprobaron todo lo que las grandes tecnológicas promovieron a través de diversos actores y vías.

Al mismo tiempo, quienes se oponían a esta farsa fueron sistemáticamente condenados al ostracismo. Sin embargo, es posible que acaben riendo los últimos en un futuro de crisis vinculada a la IA . (Dejaré esta línea de investigación para otro día).

Hay otras cuestiones espinosas que considerar: ¿cómo se define un “crimen de guerra cometido por IA” dentro de un marco jurídico internacional? ¿Es posible siquiera llegar a un consenso universal?

El operador de un dron armado responsable de aniquilar a decenas de civiles podría achacar el desastre a un fallo de la inteligencia artificial.

El software que ejecuta el dron puede tener algoritmos procedentes de varias entidades privadas de todo el mundo.

¿Quién debería asumir la culpa en caso de un crimen de guerra? ¿El operador, el proveedor responsable de la integración del software o la entidad cuyo algoritmo se utilizó o adaptó para atacar? Siendo realistas, debería ser la nación antagonista, pero nunca hay que apostar todo a la restitución si el culpable resulta ser Estados Unidos o un aliado cercano como Israel.

Por último, pero no por ello menos importante, los gobiernos de todo el mundo actuaron como co-conspiradores en el uso de la IA por parte de Google para censurar puntos de vista científicos disidentes y resultados de investigaciones contrarias durante la llamada pandemia de COVID-19. Al hacerlo, han otorgado a las grandes tecnológicas una influencia permanente para chantajearlas.

Además, ¿qué cree usted que facilita la investigación de armas biológicas en unos 400 laboratorios vinculados con el ejército estadounidense en todo el mundo? La experimentación microbiana con ganancia de función no es posible sin la IA.

RT: Las herramientas de inteligencia artificial en áreas no militares de la vida, como la generación de textos o imágenes, aún están lejos de ser perfectas. ¿No es demasiado pronto para confiar en ellas en la guerra?

Dr. Mathew Maavak: La generación de textos e imágenes por IA puede utilizarse sin duda en la guerra, y esto ya se está convirtiendo en una preocupación importante en los escenarios de conflicto modernos. El contenido generado por IA puede utilizarse como arma a través de textos generados por IA (propaganda, desinformación, etc.); imágenes o deepfakes generados por IA (por ejemplo, para subvertir los liderazgos o el consenso nacional); inteligencia falsa (por ejemplo, para crear casus belli) y comunicaciones suplantadas (por ejemplo, para subvertir la cadena de mando), entre otros. ¡Las posibilidades aquí son simplemente infinitas!

La IA está evolucionando a un ritmo exponencial. ¡La ciencia ficción de ayer es la realidad de mañana!

RT: Como informó recientemente el Washington Post, Google parece haber proporcionado herramientas de inteligencia artificial a las Fuerzas de Defensa de Israel (IDF) desde el comienzo de su campaña en Gaza. ¿Podría estar relacionado con esto el cambio en los principios de inteligencia artificial de la empresa?

Dr. Mathew Maavak: Lo dudo mucho. El uso que hace el ejército de los servicios de computación en la nube de Google y de las herramientas relacionadas (se mencionó a Amazon como alternativa) podría ser presentado como el punto de partida canónico para la militarización de la IA. Pero ¿por qué querrían las fuerzas de defensa israelíes que una fuerza laboral civil multinacional con base en los Estados Unidos tuviera acceso a sus operaciones militares?

Si Google hubiera proporcionado herramientas de inteligencia artificial a las Fuerzas de Defensa de Israel, lo habría hecho siguiendo las directivas del Estado profundo de Estados Unidos. Una entidad nominalmente civil no puede suministrar unilateralmente herramientas de inteligencia artificial sensibles para uso en tiempos de guerra a ninguna potencia extranjera, aliada o no.

Lógicamente hablando, la participación de Google en la matanza de Gaza debería dar lugar a un boicot masivo por parte de los estados miembros de la Organización de Estados Islámicos (OCI). Pero esto nunca ocurrirá, ya que demasiados políticos, “tecnócratas” y académicos de la OCI están en deuda con el patrocinio de Estados Unidos. (El escándalo actual de USAID es sólo la punta del iceberg, que revela el alcance de la subversión internacional en juego). Los defensores del mérito, los prejuicios y la no discriminación también son prácticamente inexistentes en el bloque de la OCI, aunque forman los pilares de la gobernanza de la IA.

En definitiva, los principios de la IA tal como están actualmente, ya sea en el ámbito civil o militar, no son más que un tigre de papel.

RT: Nuevamente en relación con las FDI, ha sido...Se reveló que muchas de las muertes de civiles en Gaza aparentemente no fueron resultado de herramientas de inteligencia artificial deficientes, sino de una supervisión humana negligente. ¿Tal vez la inteligencia artificial militar, si se utiliza correctamente, podría realmente conducir a una guerra más humana?

Dr. Mathew Maavak: Sinceramente, no creo que la inteligencia artificial haya desempeñado un papel importante en la guerra genocida en Gaza. El uso de la inteligencia artificial habría conducido a una campaña militar dirigida, no a una locura sangrienta de terror. No se trató de un “descuido” , sino de algo intencionado.

Si comparamos las recientes acciones de Israel en Gaza con la campaña militar relativamente profesional que llevó a cabo en la misma zona en 2014, cuando la inteligencia humana (HUMINT) y la inteligencia electrónica (ELINT) desempeñaron un papel más importante que la inteligencia artificial, ¿la inteligencia artificial ha vuelto tontas a las FDI o se la está utilizando como chivo expiatorio de los crímenes de guerra de Israel?

Sin embargo, la pregunta más importante es la siguiente: ¿por qué el sistema de seguridad fronteriza coordinado por inteligencia artificial de las FDI no detectó las actividades militares de Hamás en el período previo a los ataques transfronterizos del 7 de octubre de 2024? El sistema está equipado con múltiples sensores y herramientas de detección en tierra, mar, aire y bajo tierra, lo que hace que el fallo sea aún más desconcertante.

En última instancia, la IA se está utilizando como arma en todas las facetas de la vida humana, incluida la religión , y las grandes empresas tecnológicas estadounidenses están a la cabeza. En última instancia, en determinadas circunstancias del futuro, la IA podría utilizarse para actuar como juez, jurado y verdugo. Podría decidir quién es digno de vivir y quién no.

Estamos viviendo tiempos realmente interesantes.

https://www.rt.com/news/612575-ai-may-become-judge/